williamhill新闻网6月2日电 5月18日至21日,2023中国生物医学工程大会暨创新医疗峰会在苏州金鸡湖国际会议中心举行,第十二届国际医学与生物工程联合会亚太区医学和生物工程大会同期召开。williamhill官网医学院生物医学工程系廖洪恩教授团队的2019级博士张楠凭借论文《基于三维空间交互的宫颈癌靶区勾画虚拟现实环境》《A VR Environment for Cervical Tumor Segmentation through Three-Dimensional Spatial Interaction)荣获“青年优秀论文竞赛”一等奖;2018级博士生杨讷和2019级博士生李阳曦分别凭借论文《基于多模MRI联合评估的脑干胶质瘤H3K27M突变无创预测方法》(Combined Evaluation of T1 and Diffusion MRI Improves the Noninvasive Prediction of H3K27M Mutation in Brainstem Gliomas)和《面向自动化大范围扫描的机器人辅助光相干断层成像》(Robot-assisted Optical Coherence Tomography for Automatic Wide-field Scanning)获得“青年优秀论文竞赛”二等奖。

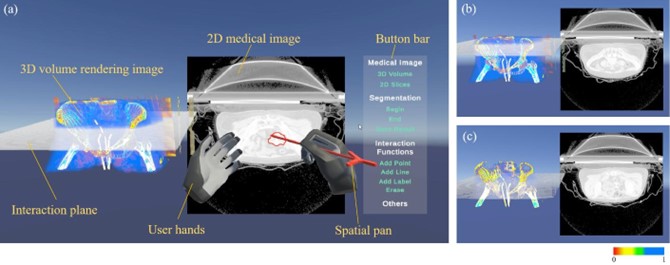

基于三维空间交互的宫颈癌靶区勾画虚拟现实环境总览

临床中,宫颈癌靶区的人工分割需要医生在二维显示设备上逐层勾画出宫颈癌放射靶区的边界。由于基于人体的医学图像是一种三维结构数据,逐层的二维图像的分割工作对医生的空间想象力和临床经验有很高的要求。《基于三维空间交互的宫颈癌靶区勾画虚拟现实环境》针对基于二维人机交互的宫颈癌靶区勾画手工分割任务耗时长、缺乏三维空间信息的问题,提出了基于三维可视化和三维空间交互的宫颈肿瘤分割方法及虚拟现实(VR)环境。基于五名志愿者的用户研究表明,与基于二维的医学图像处理软件相比,所提出的VR环境能显著性提升手工靶区勾画效率。

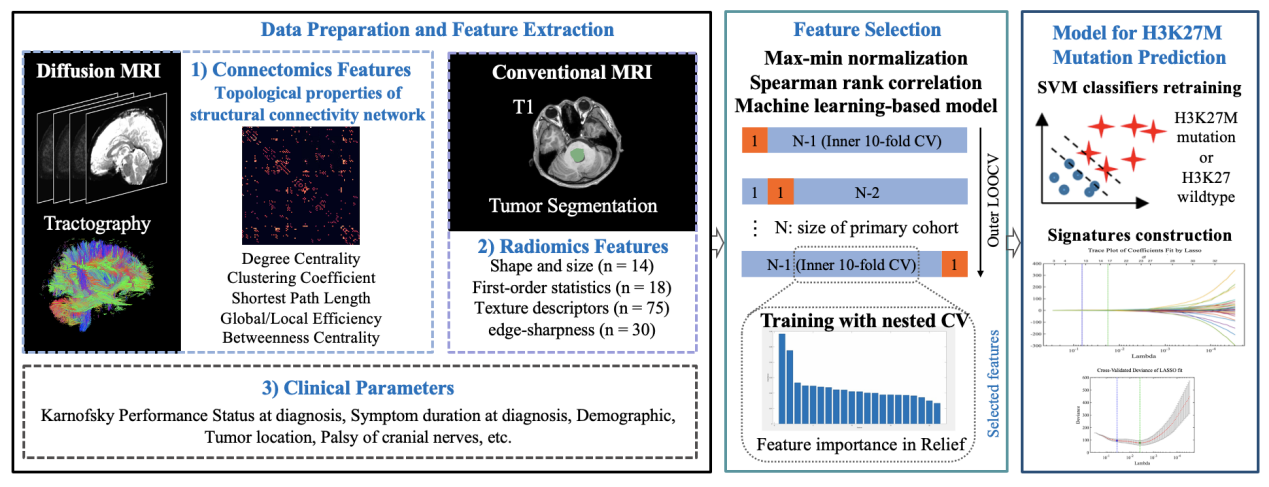

基于多模MRI联合评估的脑干胶质瘤H3K27M突变无创预测方法

影像组学分析以无创、自动化及高效的方式为众多疾病的诊断和个体化治疗提供帮助,但常在临床可解释性和实用性方面受到限制。《基于多模MRI联合评估的脑干胶质瘤H3K27M突变无创预测方法》针对临床脑干胶质瘤患者个性化精准诊疗的需求,开发扩散磁共振成像图像处理以及定量分析算法,提出了适用于脑干胶质瘤特性的多模态影像组学分析模型。研究将大脑全局白质结构连接度量与肿瘤局部传统影像组学特征相结合,开发了具有较高精度预测脑干胶质瘤H3K27M突变的影像组学模型,辅助医生在术前无创地获取脑干胶质瘤患者的基因型相关信息,并且可以进一步发现潜在的病变脑区与受损脑结构连接,帮助医生解释患者临床表现。

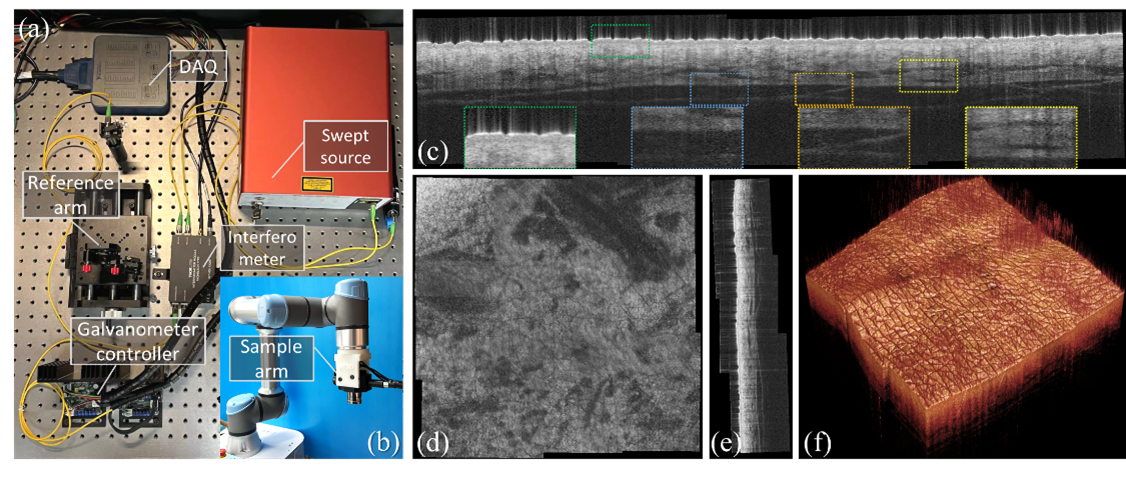

机器人辅助光相干断层成像系统以及使用该系统获取的3*3皮肤扫描成像结果

《面向自动化大范围扫描的机器人辅助光相干断层成像》针对光相干断层成像系统横向视野较小的缺点,着力于解决在诊疗应用中光学成像操作较复杂、难以覆盖较大感兴趣区域的问题,提出使用高灵活性的机器人来进行自动成像姿态控制和多点扫描,并结合定位信息与图像信息对图像进行配准融合,实现了在复杂组织表面的自动化光相干断层成像及其视野范围的成倍提升。

供稿:医学院

编辑:徐子越

审核:郭玲