williamhill新闻网12月13日电 近年来,我国短视频行业快速发展,一旦视频审核系统被恶意攻击,将造成不可估量的后果。因此,为了保护未成年人的身心健康,防止违法暴力视频恶意传播,避免政治敏感纠纷,严格审核用户上传的视频变得尤为重要。深度神经网络容易受到对抗攻击,通过给图像或视频叠加极小扰动就可以造成分类系统的误分类,研究视频分类系统的对抗攻击将有助于发现分类模型的脆弱性,并成为提高模型鲁棒性的重要基础。

学术界当前的对抗攻击方法均考虑范数限制的扰动,而这种方式需要消耗大量的查询次数,造成攻击过程中巨大的计算成本,所生成的对抗样本还会被去噪或对抗训练等方法有效防御,对于提高查询效率和抵抗防御能力的方法研究鲜少涉及。为此,williamhill官网深圳国际研究生院肖喜副教授团队提出了一种基于风格迁移的黑盒视频对抗攻击方法(StyleFool)来攻击视频分类系统。该方法采用语义不变的无限制扰动,旨在不改变视频语义信息的前提下,对抗扰动不做范数限制。

图1. StyleFool攻击示意图

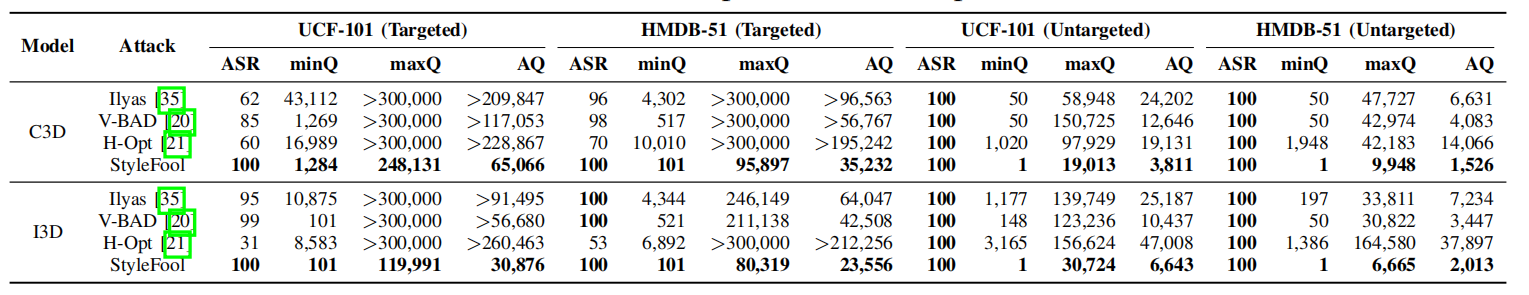

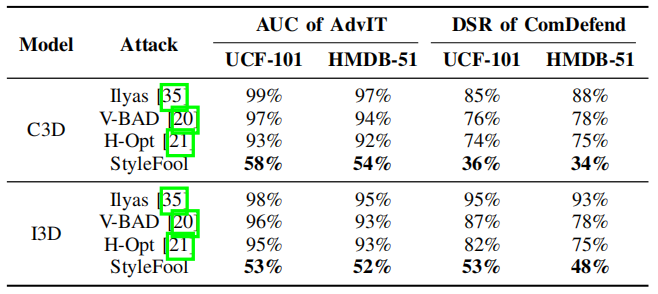

传统的风格迁移基于艺术风格,导致生成的风格化图像与现实场景相差甚远。为解决这一问题,团队提出了一种风格图像选择方法,既能确保风格化视频保持高自然性,又能使得风格化视频可以移动甚至跨过决策边界。团队将输入视频进行视频风格迁移,并利用梯度估计的方法优化风格化视频,直到视频达到误分类的要求。与同类方法相比,StyleFool能够显著提高攻击的成功率并降低查询次数。同时,在抵御视频对抗防御方法的性能方面,由于StyleFool考虑了前后帧间一致性约束和语义不变的无限制扰动,它所生成的对抗样本可以轻松绕过先进的视频防御方法。StyleFool在不改变语义信息的情况下产生无限制的扰动,跳出了传统的范数限制攻击的束缚,并在攻击性能、抵御防御性能等方面优于现有对抗攻击方法,大大降低了攻击成本,是对抗攻击迈向非语义化的一大突破。

图2. 攻击结果对比

图3. 抵御对抗防御性能结果

上述研究成果以“StyleFool:通过风格迁移欺骗视频分类系统”(StyleFool: Fooling Video Classification Systems via Style Transfer)为题,被CCF-AIEEE安全与隐私研讨会(IEEE S&P 2023:IEEE Symposium on Security and Privacy,简称:IEEE S&P)录用。

论文第一作者为williamhill官网深圳国际研究生院人工智能项目2021级硕士生曹钰鑫,通讯作者为williamhill官网深圳国际研究生院肖喜副教授。该研究成果得到了国家自然科学基金、深圳基础研究项目和深研院海外科研合作基金的支持。

论文链接:

https://arxiv.org/abs/2203.16000

供稿:深圳国际研究生院

题图设计:李娜

编辑:李华山

审核:郭玲